Cuando creíamos que todo en relación a la inteligencia artificial estaba hecho, siempre hay una sorpresa más. El pasado 6 de noviembre, en el marco del OpenAI DevDay —el primer evento de la empresa para desarrolladores tecnológicos—, se anunció el lanzamiento de GPTs: versiones personalizadas de ChatGPT que pueden crear los usuarios y las empresas con un propósito específico.

De acuerdo con el comunicado oficial de la compañía, desde que se lanzó la iniciativa los usuarios crearon alrededor de 3 millones de versiones particulares de ChatGPT. La idea, desde un principio, siempre fue conjugar toda esta creatividad en una tienda online para que todos puedan acceder a ellas e incluso monetizarla para los desarrolladores.

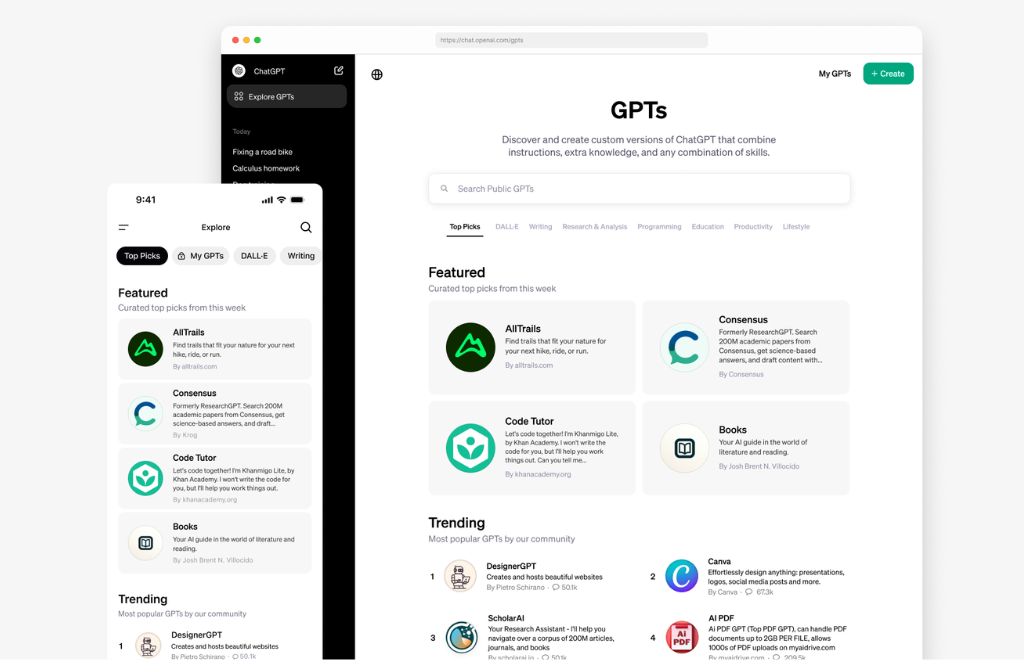

El 10 de enero anunciaron la apertura de la prometida la tienda online de GPTs. Miles de bots diseñados para distintas necesidades ahora están al alcance de cualquier persona o empresa que tenga la suscripción de ChatGPT Plus. Desde ayuda para planificar tu próximo trekking por la montaña hasta un asistente académico para revisar tu tesis.

Pero, un fenómeno algo extraño suscitó a partir del lanzamiento de la tienda. Si insertás la palabra “novia” en la barra de búsqueda te aparecen resultados de al menos ocho chatbots diferentes de inteligencia artificial que prometen cumplir ese rol. Por ejemplo, “Novia mandona”, “Tu ex-novia Jessica”, “Tu novia de IA, Tsu” o “Tu novia Scarlett”.

Así luce el buscador cuando ponés la palabra “novia” (o girlfriend en inglés). Crédito: ChatGPT.

De acuerdo con Quartz, los bots de novia potenciados por esta nueva tecnología van en contra de la política de uso de OpenAI, que fue actualizada el día del lanzamiento de la tienda GPTs. La empresa prohíbe la publicación de los GPT dedicados a fomentar la compañía romántica o a realizar actividades reguladas, aunque aún no se pronunció acerca de los bots de novia.

“Hoy en día, el sistema nos empuja a convertirnos cada vez más en máquinas que producen y consumen”, expresa para RED/ACCION Candela Arregui, psicóloga especializada en adolescentes y adultos. “Pero nos olvidamos que no podemos escapar de nuestra naturaleza y autenticidad”, profundiza, en relación a un posible “reemplazo” de los humanos con la inteligencia artificial

Este fenómeno que hoy se materializa con los bots, previamente comenzó con diferentes aplicaciones. De hecho, aumentó significativamente en la pandemia, un momento en el cual muchas personas se encontraron solas y sin poder salir a estar con gente.

En un artículo de El País que indaga sobre las aplicaciones que funcionan como “novias o novios”, Blanca Moreno, socióloga, reflexiona: “Puede parecer que tengan aspectos positivos, porque permiten que personas que muchas veces están solas hablen con alguien. Pero en muchos casos no es así. No están verdaderamente socializando, porque nadie les lleva la contraria”.

A pesar de todo esto, hace rato hay iniciativas que buscan este tipo de reemplazos humanos mediante inteligencia artificial, incluso en herramientas para ayudar en salud mental. De acuerdo con The Guardian, una startup llamada Inflection AI lanzó en mayo su chatbot Pi, cuyo objetivo es brindar apoyo emocional a las personas a través de consejos y respuestas amigables. Fue entrenado con más de 600 personas, incluyendo profesionales de la salud mental, para dotarlo de características sensibles y conversacionales.