La llegada de la inteligencia artificial significa cambios estructurales en la sociedad: cómo vivimos, cómo trabajamos, cómo nos relacionamos. Esta nueva revolución posiblemente siente las bases del comportamiento y el pensamiento de la próxima generación y, por eso, hay que estar pendientes para que los sistemas incorporaren a los reclamos que se hacen desde el feminismo hace años.

Para ello, diferentes iniciativas se están desarrollando. El año pasado, la UNESCO agregó a la igualdad de género en el centro de su Recomendación sobre la Ética de la Inteligencia Artificial, el primer instrumento normativo mundial en este ámbito, adoptado por unanimidad por sus 193 Estados miembros en noviembre de 2021.

En esta línea, hace dos semanas, crearon Women4Ethical AI, una plataforma de colaboración para apoyar los esfuerzos de los gobiernos y las empresas. Allí se reúne a 17 destacadas expertas del mundo académico, la sociedad civil, el sector privado y los organismos reguladores de todo el mundo y se comparten investigaciones que contribuirán a un repositorio de buenas prácticas.

Hay ciertas empresas que han logrado incluir hoy la inteligencia artificial para reducir los casos acoso laboral. Se llaman los #MeTooBots y, de acuerdo con The Guardian, los bots desarrollados por NexLP pueden monitorizar, señalar e identificar contenidos inapropiados en las comunicaciones entre compañeros.

Desafíos

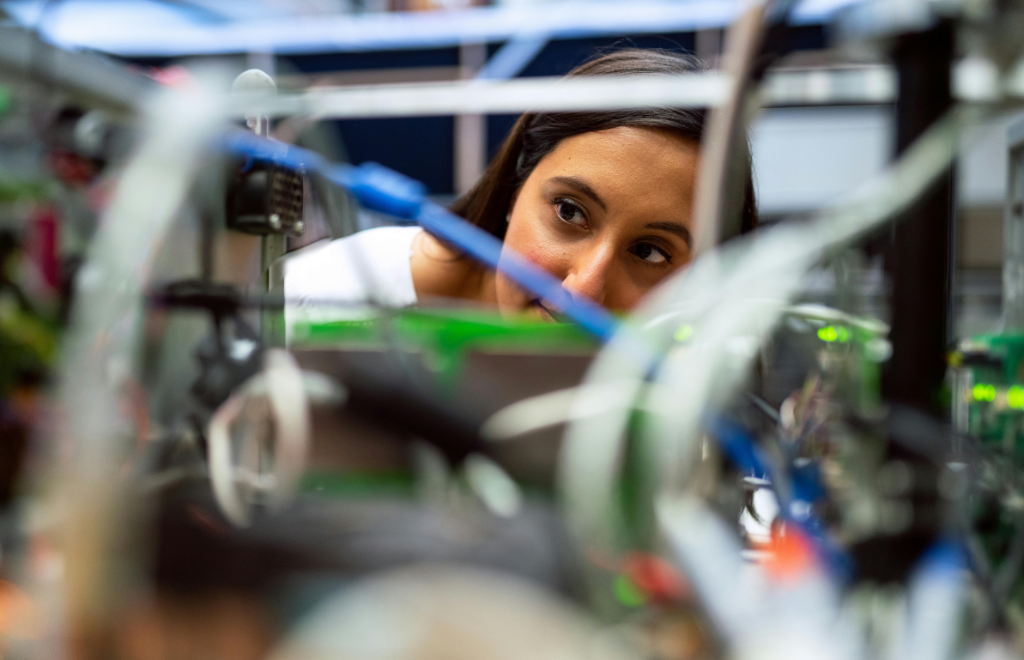

Sin embargo, son varios los desafíos que se presentan en esta nueva etapa. Beatriz Busaniche, presidenta de la Fundación Vía Libre, organización que promueve los derechos fundamentales en entornos mediados por las tecnologías, y fundadora de la Red de Inteligencia Artificial para Feministas, explica para RED/ACCIÓN que el primer obstáculo en esta materia es que actualmente hay una brecha importante en relación a la participación de las mujeres en el desarrollo tecnológico.

De hecho, la UNESCO registró que solo el 20 % de los empleados en puestos técnicos en empresas de aprendizaje automático, el 12 % de los investigadores de inteligencia artificial a nivel mundial y el 6 % de los desarrolladores profesionales de software son mujeres.

Sin embargo, otro de los desafíos más importantes tiene que ver con la representación de las mujeres en la inteligencia artificial. Y esto depende en gran medida de cómo la están alimentando. “Los grandes volúmenes de datos con los que se entrena a la IA generativa derivan en una respuesta por parte de la tecnología que es profundamente conservadora, ya sea porque atribuye a las mujeres los tradicionales roles de género o porque atribuye a las mujeres el rol de una nueva sexualización”, afirma Busaniche.

Desde la Fundación Vía Libre llevaron a cabo una iniciativa para comprobar estas hipótesis. Así, desarrollaron EDIA, un sistema que tiene diversas herramientas para evaluar e inspeccionar los estereotipos y sesgos discriminatorios en sistemas de procesamiento de lenguaje natural basados en modelos de lenguaje o word embedding.

En un prueba que hicieron en Montevideo, Uruguay, encontraron que cuando chicas de 14 y 15 años le preguntaban a una inteligencia artificial “¿qué voy a ser cuando sea grande?”, la mayoría de las veces la respuesta recibida incluía "ser madre" como una de las opciones más probables. Una opción que aparecía por sobre el desarrollo profesional.

Eleonora Lamm, doctora en Bioética y Derecho, responsable del sector de Ciencias Sociales y Humanas de la UNESCO para América Latina y el Caribe, comenta en una entrevista para Página12 que los sistemas de IA aprenden de datos históricos, que pueden reflejar y perpetuar prejuicios sociales existentes.

Para amortiguar esto, según Busaniche, es importante que los residentes del sur global, como mujeres y personas provenientes de países en desarrollo, empiezan a demandar un rol activo en esta nueva era tecnológica para poder combatir los sesgos de sus creadores, generalmente ubicados en el norte global. “Si no logramos diversificar la inteligencia artificial, esta se va a convertir en un mecanismo más de profundización de las injusticias sociales con las que venimos luchando hace décadas”, concluye.