En los medios, Geoffrey Hinton es llamado el “padrino de la Inteligencia Artificial”. El académico, de origen británico, dedicó su vida al desarrollo de tecnologías. En los años setenta, planteó la idea de crear una “red neuronal”. Se trataba de un sistema que adquiere ciertas capacidades a través del análisis de datos.

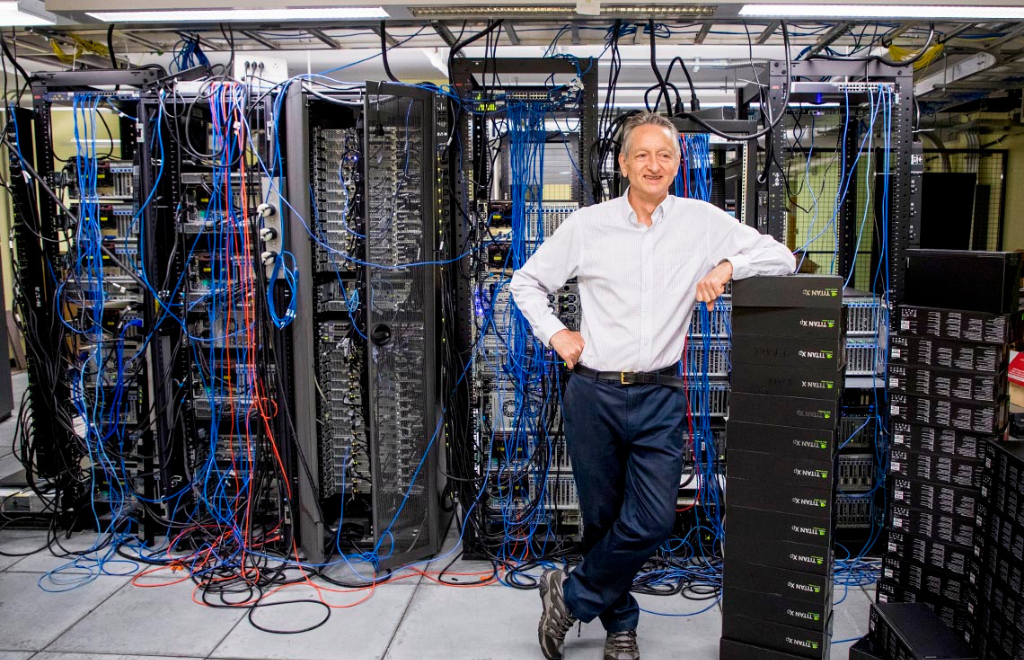

Luego, en 2012, junto a dos de sus alumnos en la Universidad de Toronto, creó una tecnología que se convirtió en la base intelectual de los sistemas de IA. Muchas empresas la consideran clave para el desarrollo y el futuro de esta tecnología. Esta última podía analizar miles de fotos y enseñarse a sí misma como identificarlas.

Hoy, el desarrollo de sus ideas se materializó a través de diferentes herramientas abiertas al público, como ChatGPT, creado por la empresa OpenIA. Sin embargo, no es algo de lo que Hinton esté muy contento, sino más bien, alarmado.

“Me consuelo con una excusa normal: si yo no lo hubiera hecho, alguien más lo habría hecho”, confiesa el Doctor Hinton en una entrevista con The New York Times. Así comienza una extensa serie de declaraciones en las cuáles el académico explica por qué hoy se aleja del mundo de la IA y su temor al futuro frente al desarrollo exponencial e imparable de esta tecnología.

El distanciamiento comenzó la semana pasada, cuando Hinton decidió renunciar a su puesto en Google, la empresa que hace unos años invirtió 44 millones de dólares para adquirir las tecnologías que el académico había desarrollado. Así, su sistema creó avances como Google Bard, un bot conversacional a base de IA (parecido a Chat GPT).

Con la introducción de estas nuevas herramientas la visión de Hinton cambió. De pensar que las tecnologías siempre serían inferiores a la inteligencia humana pasó a pensar que, en realidad, la IA podría estar acercándose a cierto punto de igualdad o incluso de superioridad. “Quizás lo que está pasando en estos sistemas sea incluso mucho mejor que lo que esté pasando en los cerebros”, confiesa el académico.

No obstante, esta opinión no podía ser difundida mientras Hinton siguiera trabajando para Google. De hecho, días después del lanzamiento de Chat GPT, grandes líderes escribieron una carta expresando los riesgos de la IA. El británico no la firmó y expresó que no iba a criticar públicamente a Google cuando aún pertenecía al staff, ya que esto podría impactar de manera negativa a la empresa. Hablaría de los riesgos de la IA una vez que haya renunciado. O sea, ahora.

In the NYT today, Cade Metz implies that I left Google so that I could criticize Google. Actually, I left so that I could talk about the dangers of AI without considering how this impacts Google. Google has acted very responsibly.

— Geoffrey Hinton (@geoffreyhinton) May 1, 2023

Algunas de sus preocupaciones incluyen que en poco tiempo la internet se llenará de fotos, videos y textos falsos. “Ya nadie podrá saber qué es verdad”, reflexionó Hinton. De hecho, fue comprobado hace un mes con las fotos del Papa Francisco o con las de Trump arrestado.

A su vez, el famoso “reemplazo” del que se habla alarma al académico. Muchas de las tareas de trabajo que realizan las personas pueden ser sustituidas por bots como Chat GPT. Por ejemplo, la traducción de un texto. “Esto quita el trabajo pesado”, profundizó Hinton. “Pero puede quitarnos más que eso”, continuó.

Al final del día, lo que deja al británico sin sueño es que los sistemas de IA aprenden comportamientos inesperados por la cantidad de datos que analizan. De esta manera, la IA puede ejecutar su propio código, además de generarlo. “Pocas persona creían en la idea de que esta tecnología podría volverse más inteligente que los humanos”, explicó para The New York Times. “Yo pensaba que estaba muy lejos de la realidad. Ya no creo lo mismo”

Si bien muchos expertos no coinciden con Hinton y declaran que estas amenazas pueden ser hipotéticas, el académico establece que la competencia por el desarrollo de tecnologías de IA podría crecer de una forma global. Lo curioso es que, a diferencia del desarrollo de bombas nucleares, el progreso de esto último puede ser en secreto, sin que nadie sepa. “No creo que deberían seguir escalando si todavía no entienden si podrán controlarlo o no”, concluyó Hinton en sus declaraciones para The New York Times.